Now Reading: Estudo revela que inteligência artificial pode ser usada para inserir falhas ocultas em chips de computador

-

01

Estudo revela que inteligência artificial pode ser usada para inserir falhas ocultas em chips de computador

Estudo revela que inteligência artificial pode ser usada para inserir falhas ocultas em chips de computador

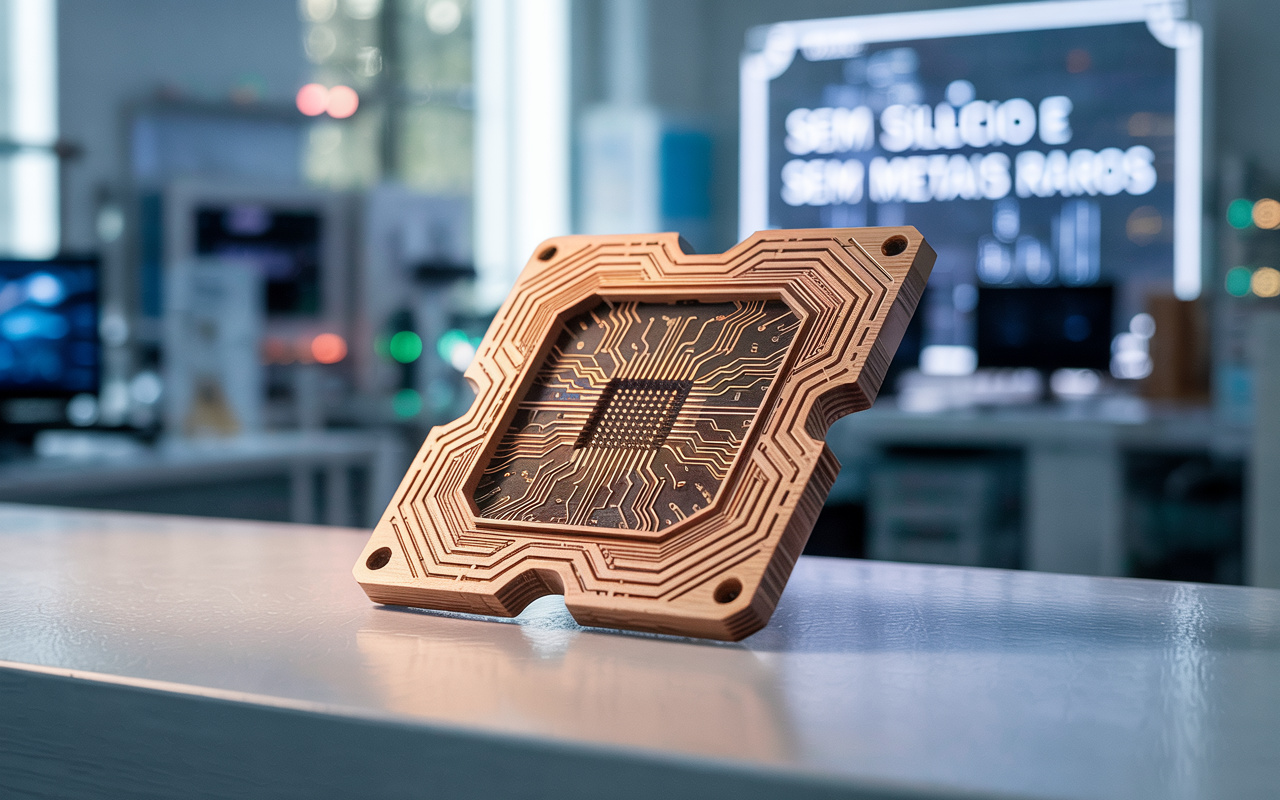

Uma pesquisa publicada nesta semana acendeu um novo sinal de alerta na indústria global de tecnologia: ferramentas baseadas em inteligência artificial podem ser usadas para inserir falhas intencionais — e quase imperceptíveis — em projetos de chips, comprometendo sua segurança desde a fase de fabricação.

O estudo, conduzido por especialistas do MIT e da Universidade de Cambridge, mostra que modelos de aprendizado de máquina podem ser treinados para manipular sutilmente circuitos integrados, incluindo “portas lógicas defeituosas” ou alterações estruturais difíceis de detectar em auditorias tradicionais.

“Estamos lidando com um novo tipo de ameaça: vulnerabilidades projetadas por IA que escapam aos métodos clássicos de verificação e podem ser exploradas remotamente após a fabricação”, alerta o professor Andrew Palmer, coautor do estudo.

Os pesquisadores simularam ataques em três tipos diferentes de circuitos digitais e conseguiram implantar falhas funcionais que comprometem a integridade ou a privacidade de dados, sem afetar o desempenho geral dos chips — tornando os problemas invisíveis até que um ciberataque seja disparado.

Implicações para segurança nacional e cibernética

O achado preocupa governos, fabricantes de hardware e setores estratégicos como defesa, telecomunicações e infraestrutura crítica. Em um cenário onde cadeias de fornecimento de chips são cada vez mais complexas e globalizadas, a possibilidade de interferência via IA levanta dúvidas sobre a confiabilidade dos produtos usados em sistemas bancários, satélites, veículos conectados e dispositivos médicos.

O estudo sugere que, em um futuro próximo, auditorias de segurança de chips precisarão incluir varreduras baseadas em IA, além de novas camadas de autenticação digital no design de semicondutores.

Empresas como Nvidia, AMD e Qualcomm acompanham o caso com atenção, e o tema já chegou a fóruns de cibersegurança na União Europeia e nos Estados Unidos, onde se discute a criação de protocolos internacionais para validação algorítmica de hardware.

FONTE: techxplore.com